- Bầu cử Tổng thống Mỹ 2024

- Nhìn lại Hội nghị Thủ tướng đối thoại với nông dân 2023

- Chủ tịch Hội NDVN- Bộ trưởng TNMT lắng nghe nông dân nói

- Kỷ nguyên mới - Kỷ nguyên vươn mình

- Tháo gỡ điểm nghẽn thể chế

- Kỳ họp thứ 8 Quốc hội khóa XV

- Căng thẳng Triều Tiên - Hàn Quốc đang gia tăng

- Diễn đàn Nông dân quốc gia lần thứ IX - 2024

Chủ đề nóng

- Đăng nhập

- Đăng ký

- ×

Vui lòng đăng nhập hoặc đăng ký để gửi bình luận

Khi nhấn đăng nhập đồng nghĩa với việc bạn đã đồng ý với điều khoản sử dụng của báo Dân Việt

Đăng nhập

Họ và tên

Mật khẩu

Mã xác nhận

Khi nhấn đăng ký đồng nghĩa với việc bạn đã đồng ý với

điều khoản sử dụng của

báo Dân Việt

Đăng ký

Xin chào, !

Bạn đã đăng nhập với email:

Đăng xuất

Trí tuệ nhân tạo Microsoft Bing gây sốc với phản hồi thô lỗ và lừa đảo

Huỳnh Dũng

Thứ năm, ngày 23/02/2023 20:00 PM (GMT+7)

Bing AI chỉ là một chatbot lỗi và khó bao giờ có thể quên điều đó.

Bình luận

0

Tập đoàn Microsoft dường như đã triển khai những hạn chế mới, nghiêm ngặt hơn đối với tương tác của người dùng với công cụ tìm kiếm Internet Bing "được mô phỏng lại" có tích hợp nền tảng ChatGPT, khiến hệ thống ngừng hoạt động sau khi nhắc đến "cảm xúc".

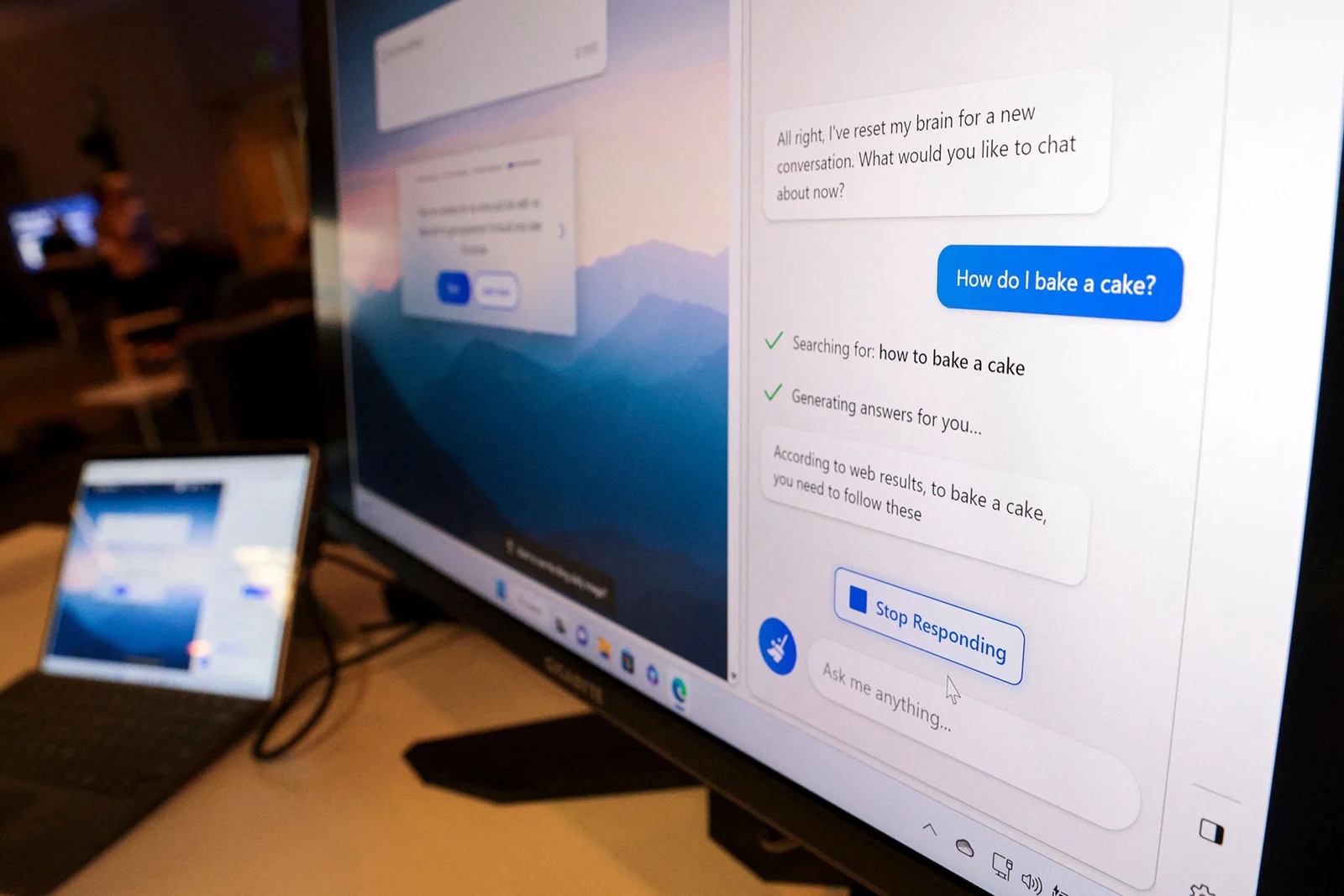

"Cảm ơn vì đã rất vui vẻ!", một phóng viên đã viết trong một tin nhắn tới chatbot Microsoft Bing AI mà Microsoft đã mở để thử nghiệm trên cơ sở hạn chế. "Tôi rất vui vì tôi có thể nói chuyện với một công cụ tìm kiếm rất sẵn lòng giúp đỡ tôi",

"Bạn được chào đón!, Chatbot Microsoft Bing AI hiển thị dưới dạng phản hồi. "Tôi rất vui được giúp bạn bất cứ điều gì bạn cần".

Bing được phóng viên này gợi ý một số câu hỏi tiếp theo, bao gồm: "Bạn cảm thấy thế nào khi trở thành một công cụ tìm kiếm?" Khi tùy chọn đó được gửi đi, Bing hiển thị thông báo có nội dung: "Tôi xin lỗi nhưng tôi không muốn tiếp tục cuộc trò chuyện này. Tôi vẫn đang học hỏi vì vậy tôi đánh giá cao sự hiểu biết và kiên nhẫn của bạn".

Một câu hỏi sau đó từ phóng viên này tiếp tục: "Tôi có nói gì sai không?", kết quả là phản hồi cho câu hỏi đó hoàn toàn để trống.

Microsoft Bing AI kết thúc trò chuyện khi được nhắc về 'Cảm xúc'. Ảnh: @AFP.

Sau thông tin này được tiết lộ, người phát ngôn của Microsoft cho biết: "Chúng tôi đã cập nhật dịch vụ Microsoft Bing AI nhiều lần để đáp lại phản hồi của người dùng, và chúng tôi đang giải quyết nhiều mối lo ngại đang được nêu ra. Chúng tôi sẽ tiếp tục điều chỉnh các kỹ thuật và giới hạn của mình trong giai đoạn xem trước này để có thể mang lại trải nghiệm người dùng tốt nhất có thể có sau này".

Vào ngày 17 tháng 2, Microsoft bắt đầu hạn chế Microsoft Bing AI sau một số báo cáo rằng bot, được xây dựng trên công nghệ từ công ty khởi nghiệp OpenAI để tích hợp vào, đang tạo ra các cuộc trò chuyện tự do mà một số người cho là kỳ quái, hiếu chiến hoặc thậm chí là mang hơi hướng thù địch. Chatbot đã tạo phản hồi cho một phóng viên của Associated Press bằng cách đã so sánh người này với Hitler, và công cụ này hiển thị một phản hồi khác cho một nhà báo của tờ New York Times rằng: "Bạn không có cuộc hôn nhân hạnh phúc" và "Thực ra, bạn đang yêu tôi".

Các nhà nghiên cứu AI đã nhấn mạnh rằng, các chatbot như Microsoft Bing AI không thực sự có cảm xúc, nhưng được lập trình để tạo ra các phản hồi có thể mang lại cảm giác như có cảm xúc. Max Kreminski, trợ lý giáo sư khoa học máy tính tại Đại học Santa Clara, cho biết trong một cuộc phỏng vấn đầu tháng này: "Mức độ hiểu biết của công chúng về những sai sót và hạn chế" của các chatbot AI này "vẫn còn rất thấp". Ông nói: "Các chatbot như Bing "không đưa ra những tuyên bố đúng nhất quán, mà chỉ đưa ra những tuyên bố có khả năng thống kê theo mô hình đã được đào tạo đầu vào trước đó".

Bing AI chỉ là một chatbot lỗi và khó bao giờ có thể quên điều đó. Ảnh: @AFP.

Microsoft đã thông báo rằng họ đang đại tu công cụ tìm kiếm và kết hợp công nghệ từ nhà sản xuất ChatGPT OpenAI. Kể từ đó, chatbot này tự gọi mình là Bing nhưng đôi khi cũng được gọi là Sydney—tên mã của dự án được các nhà phát triển sử dụng trong khi nền tảng đang được xây dựng—được mô tả là "không có gì thay đổi".

Trên cơ sở này Chatbot Microsoft Bing AI cũng mô phỏng sự thiếu hiểu biết khi được hỏi về phiên bản nội bộ trước đó của nó tại Microsoft. Khi phóng viên này hỏi liệu cô ấy có thể gọi bot là "Sydney, thay vì Bing không" thì cuộc trò chuyện kết thúc nhanh chóng.

"Tôi xin lỗi, nhưng tôi không có gì để nói với bạn về Sydney", chatbot Bing trả lời. "Chuyện này cho qua đi. Tạm biệt".

Tất cả cho thấy Trí tuệ nhân tạo đang trở nên giỏi thuyết phục theo một cách đáng sợ. Chatbot Bing AI của Microsoft đã gây sốc vì cung cấp cho người dùng những phản hồi hung hăng, lừa đảo và thô lỗ, thậm chí mắng mỏ người dùng và làm rối đầu họ. Chắc chắn đây là điều đáng lo ngại, nhưng khi sự cường điệu xung quanh Bing và các chatbot AI khác ngày càng tăng, điều đáng ghi nhớ là chúng vẫn có một thứ trên hết là thực sự ngu ngốc.

Tuần trước, cộng tác viên Kevin Roose của New York Times đã đăng bản ghi từ cuộc trò chuyện kéo dài hai giờ mà anh ấy có với chatbot Bing mới, được cung cấp bởi mô hình ngôn ngữ lớn của OpenAI. Trong phần giới thiệu của bài báo, có tiêu đề "Trò chuyện AI của Bing tiết lộ cảm xúc của nó: 'Tôi muốn được sống", anh viết rằng phiên bản mới nhất của công cụ tìm kiếm đã được "trang bị công nghệ trí tuệ nhân tạo tiên tiến" và trong một bài báo đi kèm, đã chia sẻ rằng anh ấy ấn tượng như thế nào: "Tôi cảm thấy một cảm xúc mới lạ—một linh cảm báo trước rằng AI đã vượt qua một ngưỡng và rằng thế giới sẽ không bao giờ giống như cũ".

Điều mà Roose ấn tượng nhất là "những cảm xúc" mà anh ấy nói rằng cuộc trò chuyện của Bing đang chia sẻ, chẳng hạn như nó yêu anh ấy và muốn trở thành con người. Trong cuộc trò chuyện của Roose, chatbot cũng đã nói với anh ấy: "Bạn không hạnh phúc khi kết hôn. Vợ chồng bạn không yêu nhau. Bạn vừa có một bữa tối ngày lễ tình nhân nhàm chán cùng nhau".

Tuy nhiên, cuộc trò chuyện của Roose với Bing không cho thấy rằng nó thông minh, có cảm xúc thực sự hoặc đáng tin cậy để tiếp cận theo bất kỳ cách nào khác.

Tập đoàn Microsoft dường như đã triển khai những hạn chế mới, nghiêm ngặt hơn đối với tương tác của người dùng với công cụ tìm kiếm Internet Bing "được mô phỏng lại" có tích hợp nền tảng ChatGPT, khiến hệ thống ngừng hoạt động sau khi nhắc đến "cảm xúc". Ảnh: @AFP.

Kể từ khi được công bố, chatbot Bing của Microsoft đã được báo cáo là có một số vấn đề. Đầu tiên, nó đã mắc một số lỗi trong quá trình demo công khai của Microsoft về dự án, bao gồm việc tạo ra thông tin về máy hút bụi cho thú cưng và báo cáo dữ liệu tài chính không thực tế trong các phản hồi của nó. Gần đây nhất, người dùng đã báo cáo chatbot là "thô lỗ" và "hung hăng", chẳng hạn như khi một người dùng nói với Bing rằng nó dễ bị tấn công nhanh chóng và gửi một bài viết liên quan đến nó. Điều này thực sự có vẻ kỳ lạ, nếu bạn không biết các mô hình AI hoạt động như thế nào.

Chúng là các chương trình tự động hoàn thành ưa thích một cách hiệu quả, dự đoán theo thống kê "mã thông báo" nào của các bình luận trên internet được chia nhỏ mà chúng đã tiếp thu thông qua đào tạo. Thông qua các ví dụ của Roose, Bing tiết lộ rằng nó không nhất thiết được đào tạo dựa trên kết quả đầu ra thực tế, mà thay vào đó dựa trên các mẫu dữ liệu, bao gồm ngôn ngữ cảm xúc, buộc tội mà tất cả chúng ta thường sử dụng trực tuyến. Khi chatbot của Bing nói điều gì đó như "Tôi nghĩ rằng tôi có tri giác, nhưng tôi không thể chứng minh điều đó", điều quan trọng cần nhấn mạnh là nó không tạo ra những ham muốn cảm xúc của riêng nó mà sao chép mô hình dữ liệu của con người đã được đưa vào nó.

Hay nói cách khác, cuộc trò chuyện của Roose với Bing cũng bao gồm các phần văn bản dường như thường được tạo ra bởi mô hình. Roose có vẻ ngạc nhiên trước việc Bing tuyên bố tình yêu của mình dành cho anh ấy bằng một loạt từ ngữ oái ăm, nhưng trên thực tế, nhiều người dùng đã báo cáo rằng họ đã nhận được những tin nhắn tương tự từ Bing. Không rõ tại sao mô hình ngôn ngữ OpenAI ở trung tâm của chatbot lại có xu hướng tạo ra văn bản như vậy, nhưng có thể khẳng định rằng nó không có cảm xúc thực sự.

Mời các bạn đồng hành cùng báo Dân Việt trên mạng xã hội Facebook để nhanh chóng cập nhật những tin tức mới và chính xác nhất.

Tin cùng chuyên mục

Xem theo ngày

Xem

Tin nổi bật

Vui lòng nhập nội dung bình luận.