- Bầu cử Tổng thống Mỹ 2024

- Nhìn lại Hội nghị Thủ tướng đối thoại với nông dân 2023

- Chủ tịch Hội NDVN- Bộ trưởng TNMT lắng nghe nông dân nói

- Kỷ nguyên mới - Kỷ nguyên vươn mình

- Tháo gỡ điểm nghẽn thể chế

- Kỳ họp thứ 8 Quốc hội khóa XV

- Căng thẳng Triều Tiên - Hàn Quốc đang gia tăng

- Diễn đàn Nông dân quốc gia lần thứ IX - 2024

Chủ đề nóng

- Đăng nhập

- Đăng ký

- ×

Vui lòng đăng nhập hoặc đăng ký để gửi bình luận

Khi nhấn đăng nhập đồng nghĩa với việc bạn đã đồng ý với điều khoản sử dụng của báo Dân Việt

Đăng nhập

Họ và tên

Mật khẩu

Mã xác nhận

Khi nhấn đăng ký đồng nghĩa với việc bạn đã đồng ý với

điều khoản sử dụng của

báo Dân Việt

Đăng ký

Xin chào, !

Bạn đã đăng nhập với email:

Đăng xuất

Siêu lừa đảo ghép mặt, giả giọng bằng Trí tuệ nhân tạo: Chuyên gia "vạch trần" thủ đoạn tinh vi

Khải Phạm

Thứ ba, ngày 28/03/2023 06:15 AM (GMT+7)

Gần đây, xuất hiện tình trạng lừa đảo mới khi các đối tượng xấu dùng hình ảnh, video cắt ghép mặt, giả giọng người thân để lừa đảo.

Bình luận

0

Ngày nay, tình trạng tội phạm lừa đảo công nghệ cao đang diễn ra phức tạp với nhiều thủ đoạn tinh vi. Không chỉ lừa đảo thông qua những thông tin cơ bản như họ tên, địa chỉ, loại tội phạm này đã phát triển lên tầm cao mới khi cắt ghép khuôn mặt, giả giọng tinh vi khiến nhiều người "nhẹ dạ, cả tin" mất tiền.

Lừa đảo 4.0 ngày càng tinh vi khi ghép mặt, giả giọng

Mới đây, Công an tỉnh Tuyên Quang cho biết, hiện nay xuất hiện tình trạng lừa đảo mới cực kỳ tinh vi bằng công nghệ trí tuệ nhân tạo (AI). Theo đó, các sử dụng công nghệ Deepfake AI tạo ra âm thanh, hình ảnh và video giả con người như ngoài đời thật.

Các đối tượng sau khi hoàn thành giả giọng, fake khuôn mặt sẽ thực hiện cuộc gọi video vay tiền người thân, giả làm con cái xin tiền bố mẹ hay giả người thân đi cấp cứu phải chuyển tiền gấp.

Công an cũng cho biết, các đối tượng tìm kiếm, thu thập thông tin cá nhân, hình ảnh, video có giọng nói khi người dùng đăng tải trên mạng xã hội rồi sử dụng công nghệ Deepfake để tạo sẵn những video rất khó phân biệt thật - giả với khuôn mặt, giọng nói giọng nói.

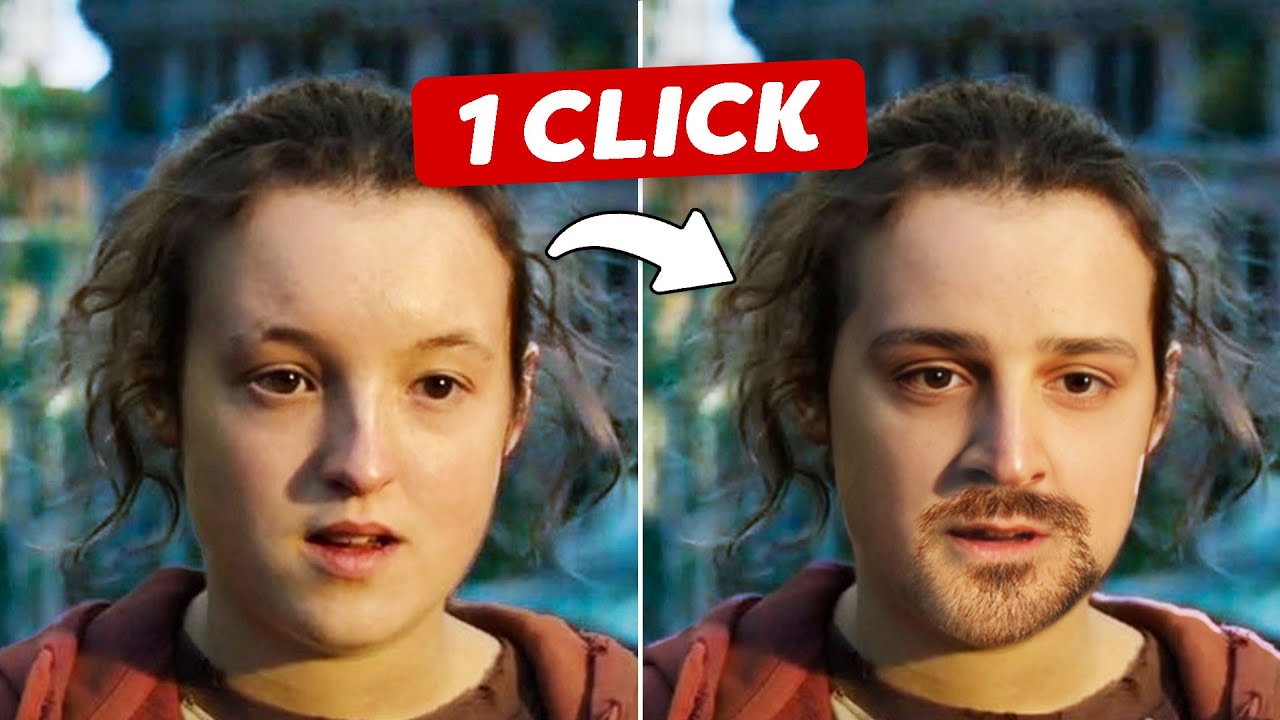

Ghép mặt, giả giọng người thân như thật để lừa đảo, chuyên gia chỉ ra nguyên nhân. Ảnh Cinecom.

Theo chuyên viên an ninh mạng, làm việc tại Trung tâm Giám sát An toàn Không mạng quốc gia (NCSC, thuộc Bộ Thông tin và Truyền thông) - Ngô Minh Hiếu (Hiếu PC): "Hiện tại công nghệ AI và đặc biệt là DeepFake ngoài được dùng để nhằm phục vụ mục đích tốt, nhưng một số thành phần lại sử dụng cho mục đích xấu như lừa đảo, giả mạo, bôi nhọ hay thậm chí là làm ra tin giả kiểu video".

Cũng theo vị chuyên gia này, Deepfake đã được tội phạm quốc tế dùng cách đây 2-3 năm, và giờ tội phạm Việt Nam bắt đầu áp dụng để lừa đảo, chiếm đoạt tài sản.

"Các thủ đoạn cắt ghép hình ảnh, giả giọng nói hiện nay đang ngày càng tinh vi hơn, những công cụ cắt ghép đang được nhiều đôi tượng xấu biết đến và thực hiện thuần thục.

Những video hướng dẫn giả mạo khuôn mặt, giọng nói xuất hiện trên Youtube để tạo deepfake sẽ tạo ra 1 làn sóng lừa đảo thế hệ 4.0 khiến nhiều người lâu nay rất khó bị lừa, nhưng giờ họ cũng có thể sẽ là đối tượng bị lừa, và những người tầm trung niên trở lên là đối tượng dễ bị lừa nhất vì họ thiếu nhận thức về an toàn thông tin và khó nhận biết kiểu lừa này, nếu không có được sự chia sẻ hướng dẫn an toàn trên không gian mạng", ông Hiếu chia sẻ.

Cách nhận diện lừa đảo người dân cần biết

Theo ông Ngô Minh Hiếu, khi xem một số video hoặc hình ảnh mà nhân vật trong đó có một số dấu hiệu kỳ lạ, có thể là khuôn mặt của họ thiếu tính cảm xúc và khá "trơ" khi nói, hoặc tư thế của họ trông lúng túng, không tự nhiên, hoặc là hướng đầu và cơ thể của họ trong video không nhất quán với nhau. Những điều này có thể sẽ là điểm đáng rất nghi ngờ và nên dừng lại để suy nghĩ.

"Ngoài ra, bạn cũng có thể phân biệt khi thấy màu da của nhân vật trong video bất thường, ánh sáng kỳ lạ và bóng đổ không đúng vị trí. Điều này có thể khiến cho video trông rất giả tạo và không tự nhiên. Âm thanh cũng là một vấn đề có thể xảy ra trong video. Âm thanh sẽ không đồng nhất với hình ảnh, có nhiều tiếng ồn bị lạc vào clip hoặc clip không có âm thanh.

Cuối cùng, có thể xảy ra tình huống mà tài khoản chuyển tiền không phải của người đang thực hiện cuộc gọi. Và thường kẻ gian sẽ ngắt giữa chừng, bảo là mất sóng, sóng yếu...

Tóm lại, các yếu tố kỳ lạ như trên là báo hiệu đỏ của deepfake. Bạn nên luôn cảnh giác và tuyệt đối bình tĩnh", ông Hiếu chỉ ra chi tiết nhận diện lừa đảo.

Bên cạnh cách nhận diện ban đầu, khi có dấu hiệu khả nghi, người dân cũng cần cảnh giác hơn để tránh bị lừa.

"Để tránh bị lừa, tốt nhất là nên tỉnh táo, khi có một ai đó trên mạng xã hội trong danh sách bạn bè của mình mà tự nhiên hỏi mượn tiền hay gửi link lạ thì không nên vội, mà hãy bình tĩnh, kiểm chứng và nên xác thực mọi thứ. Chủ động xác thực bằng cách gọi điện thoại số điện thoại trực tiếp hoặc facetime ít nhất trên 1 phút, sau đó giả vờ đặt ra những câu hỏi cá nhân mà chỉ có bạn và người kia mới biết. Vì Deepfake sẽ không thể giả được một cuộc trò chuyện thật sự trong thời gian thực mà có tính chuẩn xác cao, vì dù sao cảm xúc hay biểu cảm của AI hay Deepfake vẫn không thể bắt chước được như người thật tính tới thời điểm này", ông Hiếu PC chia sẻ.

Hiện nay, mạng xã hội không còn là một nơi an toàn, rất nhiều đối tượng đã lợi dụng đó để thu thập dữ liệu phục vụ những mục đích xấu như lừa đảo. Do đó, chuyên gia an ninh mạng này cũng đưa ra một số lời khuyên.

"Người dân cần hạn chế chia sẻ hình ảnh hay video cá nhân lên trên mạng. Luôn bảo mật tài khoản mạng xã hội, Email của mình bằng mật khẩu có độ khó cao, bảo mật 2 bước bằng phần mềm như Microsoft Authenticator.

Nếu bị làm giả, nên thông báo ngay lập tức cho mọi người biết. Và báo lên cơ quan chức năng tại canhbao.ncsc.gov.vn hay báo lên dự án chongluadao https://chongluadao.vn. Nâng cao nhận thức về nhận biết lừa đảo trên không gian mạng tại: dauhieuluadao.com. Nếu cận thận hơn, nếu chia sẻ video hay clip trên mạng nên làm méo tiếng của mình, thay bằng tiếng robot hoặc AI voice, để tránh kẻ xấu biết giọng nói thật của mình", ông Ngô Minh Hiếu đưa ra lời khuyên.

Mời các bạn đồng hành cùng báo Dân Việt trên mạng xã hội Facebook để nhanh chóng cập nhật những tin tức mới và chính xác nhất.

Tin cùng chuyên mục

Xem theo ngày

Xem

Tin nổi bật

Vui lòng nhập nội dung bình luận.